Le fichier robots.txt permet de bloquer l’accès aux robots des moteur de recherche à certaines parties de votre site. Vous voudrez par exemple demander à Bingbot de ne pas indexer une page x ou un fichier y, dans les résultats de recherche. Vous devez alors vous servir du fichier robots.txt. La plupart de sites web ont un fichier robots.txt qui masque certains contenus.🧐 Les sites web créés avec WordPress ont leur propre fichier robots.txt qui est généré automatiquement lors de l’installation de ce logiciel open source. 😇

Objectif

Dans ce tutoriel, vous apprenez à accéder au fichier robots.txt de WordPress et à le modifier en utilisant trois méthodes. En lisant minutieusement cet article, vous pouvez créer et modifier le fichier robots.txt de votre site sans qu’il soit nécessaire de faire appel à un développeur.😊

Prérequis

Tout ce dont vous avez besoin pour interagir avec le fichier robots.txt de votre site WordPress est d’un accès de niveau administrateur à votre site.

Besoin d’un hébergement WordPress rapide et de qualité ?

LWS vous conseille sa formule d’hébergement WordPress en promotion à -20% (offre à partir de 3,99€ par mois au lieu de 4,99 €). Non seulement les performances sont au rendez-vous mais vous profitez en plus d’un support exceptionnel.

Qu’est-ce que le fichier robots.txt WordPress ?

Chaque contenu que vous publiez en ligne est exploré par les moteurs de recherche afin d’être indexé et ensuite d’être référencé. Chaque page, article ou chaque image que vous créez, quelle que soit sa nature, passe par le même processus avant d’apparaître dans les résultats des moteurs de recherche.

Chaque contenu que vous publiez en ligne est exploré par les moteurs de recherche afin d’être indexé et ensuite d’être référencé. Chaque page, article ou chaque image que vous créez, quelle que soit sa nature, passe par le même processus avant d’apparaître dans les résultats des moteurs de recherche.

Pour explorer les milliers de pages web qui sont publiées en ligne, les moteurs de recherche utilisent les robots appelés également « bots ». Chaque moteur de recherche a ses propres robots d’indexation et ses règles de fonctionnement. Logiquement, toute page web qui peut être explorée sur votre site, peut être indexée puis référencée.

Certaines pages ne doivent cependant pas être référencées : par exemple, la page de connexion à votre tableau de bord WordPress. Il peut en être de même pour certaines images. Pour empêcher les moteurs de recherche de les affichier dans les résultats de recherche, il convient d’utiliser le fichier robots.txt.

Dans WordPress, le fichier robots.txt est créé automatiquement lorsque vous installez l’application sur votre espace d’hébergement.

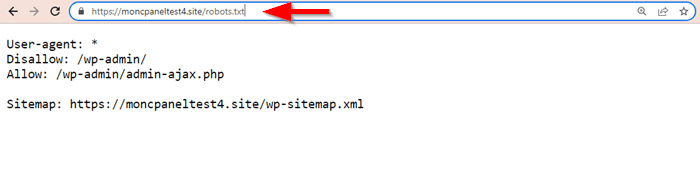

Vous pouvez accéder au contenu de votre fichier robots.txt sans la possibilité de le modifier depuis n’importe quel navigateur web. Il suffit d’ajouter l’attribut /robots.txt à votre nom de domaine dans la barre du navigateur.👇 Comme, vous pouvez le voir dans l’image ci-dessus, notre fichier ne contient que quelques instructions. Nous allons voir comment vous pouvez modifier ce contenu.

Comme, vous pouvez le voir dans l’image ci-dessus, notre fichier ne contient que quelques instructions. Nous allons voir comment vous pouvez modifier ce contenu.

Quelle est l’importance du fichier robots.txt ?

Le fichier robots.txt permet d’ajouter des règles d’exclusion et d’inclusion de certaines parties de votre site lors de l’exploration et de l’indexation par les robots de moteurs de recherche. Vous pouvez donc vous en servir pour instruire aux moteurs de recherche d’explorer et d’afficher uniquement les pages de grande valeur dans les résultats organiques.

Le fichier robots.txt permet d’ajouter des règles d’exclusion et d’inclusion de certaines parties de votre site lors de l’exploration et de l’indexation par les robots de moteurs de recherche. Vous pouvez donc vous en servir pour instruire aux moteurs de recherche d’explorer et d’afficher uniquement les pages de grande valeur dans les résultats organiques.

Ce fichier peut aussi vous aider à bloquer l’exploration de votre site par certains robots malveillants. Vous pouvez ainsi bloquer un nombre assez considérable de robots tiers qui peuvent parcourir et encombrer inutilement votre site avec un risque de le ralentir.

Où trouver le fichier robots.txt et quelles sont ses composantes ?

Le fichier robots.txt est accessible à la racine de votre site. Vous devez en conséquence accéder au dossier public_html ou www (selon les hébergeurs) pour trouver le vôtre. Et comme nous le disions plus tôt, ce fichier est virtuel. Si vous envisagez de le modifier, vous devez créer un nouveau fichier nommé robots.txt puis le placer à la racine de votre site.

Le fichier robots.txt est accessible à la racine de votre site. Vous devez en conséquence accéder au dossier public_html ou www (selon les hébergeurs) pour trouver le vôtre. Et comme nous le disions plus tôt, ce fichier est virtuel. Si vous envisagez de le modifier, vous devez créer un nouveau fichier nommé robots.txt puis le placer à la racine de votre site.

Mais avant cela, voyons quelles sont les composantes d’un fichier robots.txt. Et pour répondre à cette question, nous allons voir un exemple typique :

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Comme vous le voyez dans l’exemple ci-dessus👆, le fichier robots.txt classique de WordPress inclut généralement trois instructions :

- User-agent : cette ligne universelle permet de bloquer n’importe quel robot de moteurs de recherche. Le symbole (*) représente tous les robots. Mais par exemple, si vous souhaitez bloquer uniquement le robot de Yandex, il vous suffit de remplacer l’astérisque par YandexBot.

- Disallow : c’est la commande qui permet d’interdire aux robots d’accéder à des parties spécifiques de votre site. Dans l’exemple ci-dessus, tous les robots ont l’ordre de ne pas indexer la partie /wp-admin de notre site.

- Allow : indique aux bots d’indexer la partie spécifique de votre site que vous avez défini.

Avec ces trois lignes de commandes, vous avez des possibilités presque infinies quand il faut ou non indexer une partie spécifique de votre site.

Si vous tenez strictement à empêcher les moteurs de recherche à indexer une partie spécifique de votre site, la meilleure façon de le faire consiste à utiliser des balises noindex. Pour agir efficacement, la ressource avec la balise noindex ne doit pas être bloquée également avec le fichier robots.txt.

Comment créer un fichier robots.txt dans WordPress ?

Vous pouvez créer un fichier robots.txt si vous souhaitez ajouter des règles supplémentaires au fichier virtuel de WordPress. Dans ce cas, le fichier créé va remplacer le robots.txt par défaut. Pour ce faire, vous pouvez utiliser trois méthodes :

Méthode 1 : créer le fichier robots.txt avec le plugin All In One SEO

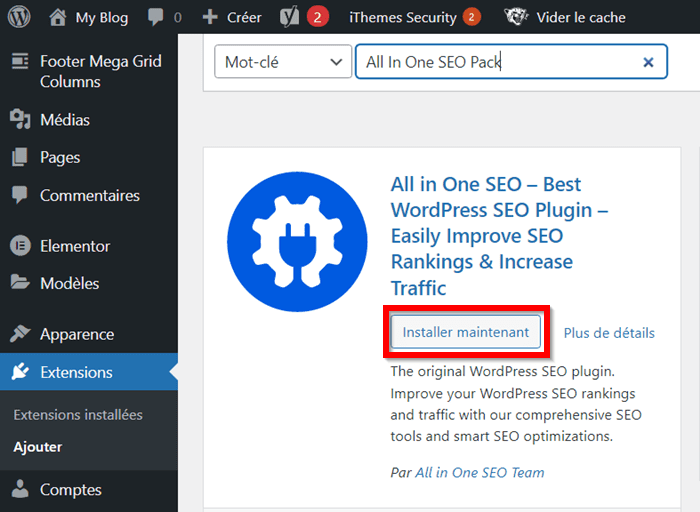

All In One SEO est connu comme un des plus populaires plugins de référencement naturel dans WordPress. Il peut être utilisé gratuitement et contient des nombreuses fonctionnalités qui le placent en tête des concurrents.

Pour ce faire, connectez-vous à l’espace d’administration de votre site et accédez à la section « Extensions › ajouter ». Ensuite, recherchez l’extension All In One SEO dans le répertoire officiel en utilisant la barre de recherche.

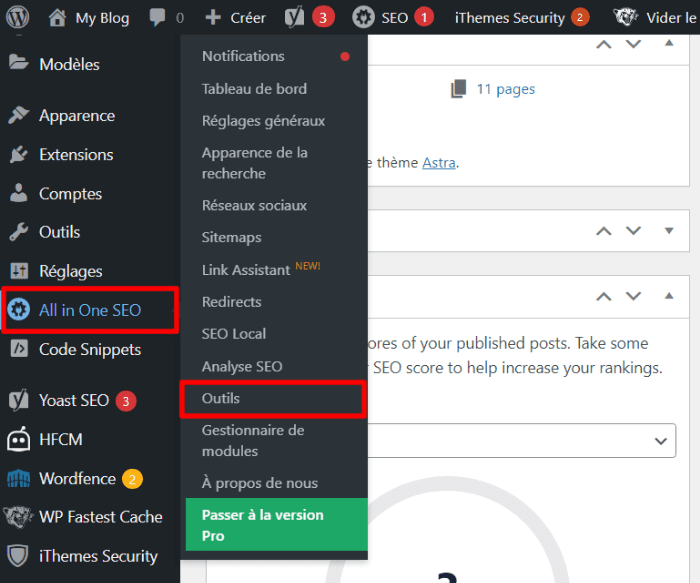

Cliquez sur le bouton « Installer maintenant », une fois que l’avez trouvé. Après l’installation et l’activation de ce plugin, rendez-vous dans la section « All In One SEO › outils » depuis votre tableau de bord.

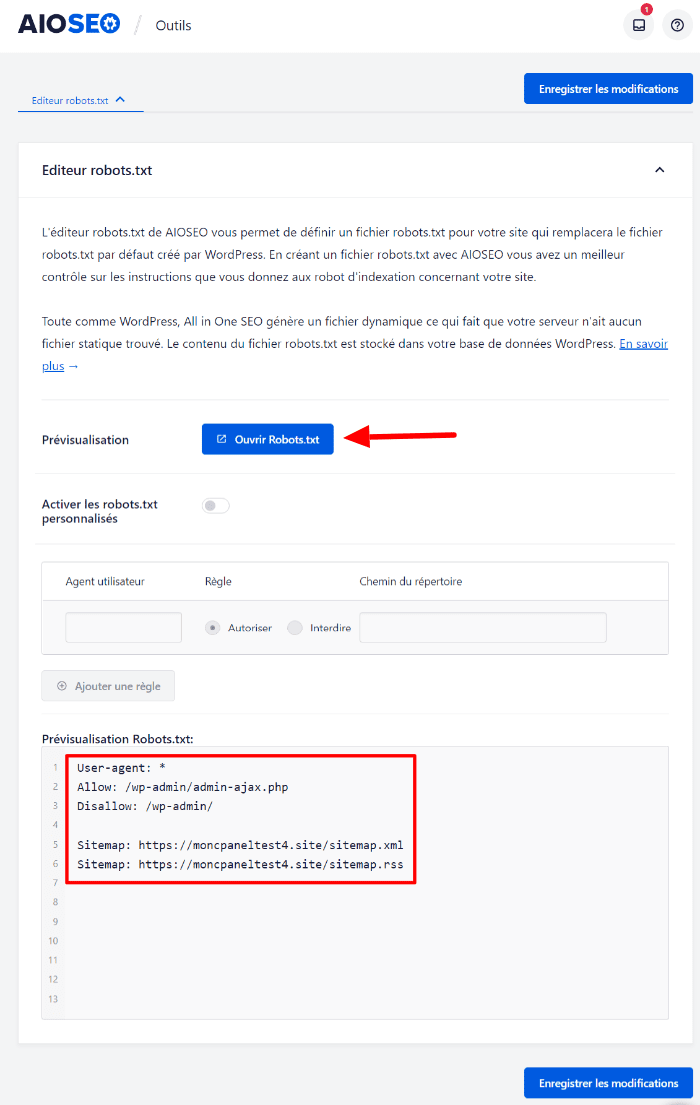

Après l’installation et l’activation de ce plugin, rendez-vous dans la section « All In One SEO › outils » depuis votre tableau de bord. Par la suite, vous serez redirigé vers une nouvelle interface. All In One SEO vous présente le fichier robots.txt par défaut de votre site. Vous pouvez également le prévisualiser dans votre navigateur en cliquant sur le bouton « Ouvrir Robots.txt ».

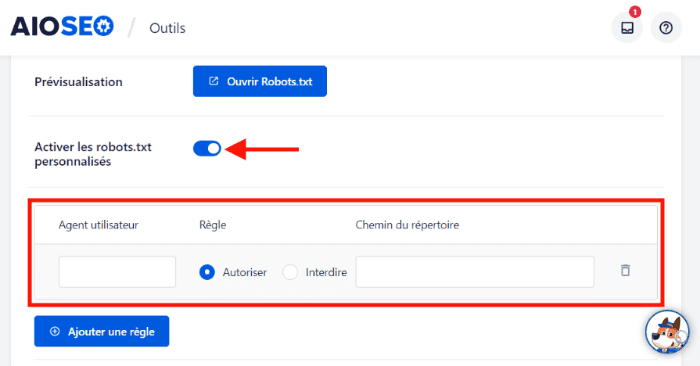

Par la suite, vous serez redirigé vers une nouvelle interface. All In One SEO vous présente le fichier robots.txt par défaut de votre site. Vous pouvez également le prévisualiser dans votre navigateur en cliquant sur le bouton « Ouvrir Robots.txt ». Ensuite, pour créer un nouveau fichier robots.txt, commencez par cocher l’option « Activer les robots.txt personnalisés ».

Ensuite, pour créer un nouveau fichier robots.txt, commencez par cocher l’option « Activer les robots.txt personnalisés ». Vous pouvez créer votre fichier robots.txt à l’aide de trois champs présentés :

Vous pouvez créer votre fichier robots.txt à l’aide de trois champs présentés :

- Agent utilisateur : ce champ permet d’ajouter votre agent utilisateur.

- Règle : choisissez entre autres les deux options : autoriser (Allow) et interdire (Disallow).

- Champ du répertoire : cette section vous permet d’ajouter des répertoires ou des dossiers que vous ne souhaitez pas indexer.

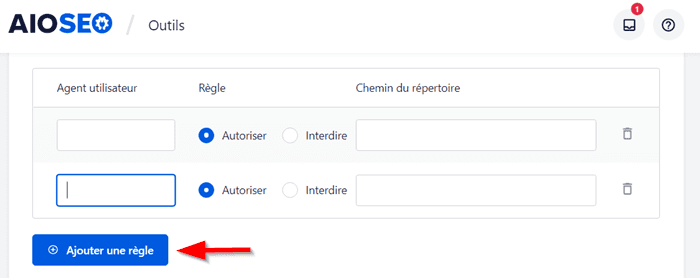

Cliquez sur le bouton « Ajouter une règle » pour ajouter une ou plusieurs règles. Enregistrez vos modifications, et c’est tout ! 😁

Enregistrez vos modifications, et c’est tout ! 😁

Méthode 2 : utiliser le plugin Rank Math pour créer un fichier robots.txt

Rank Math est une autre extension que vous pouvez utiliser pour créer un fichier robots.txt. Tout d’abord, installez ce plugin sur votre site.

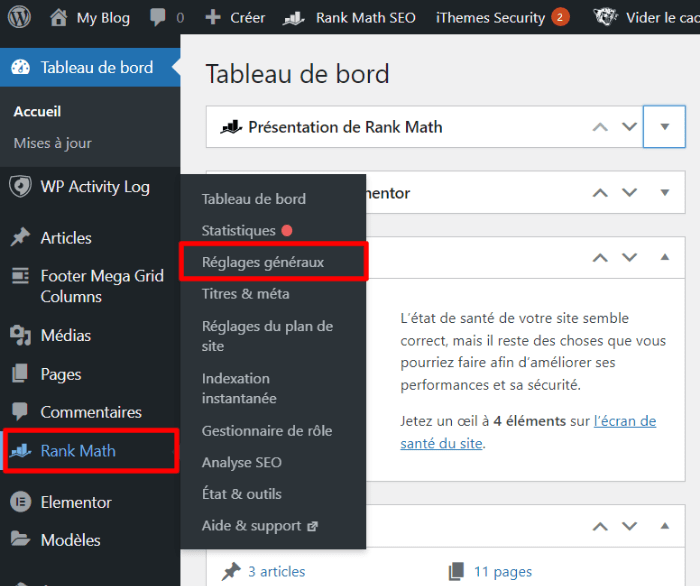

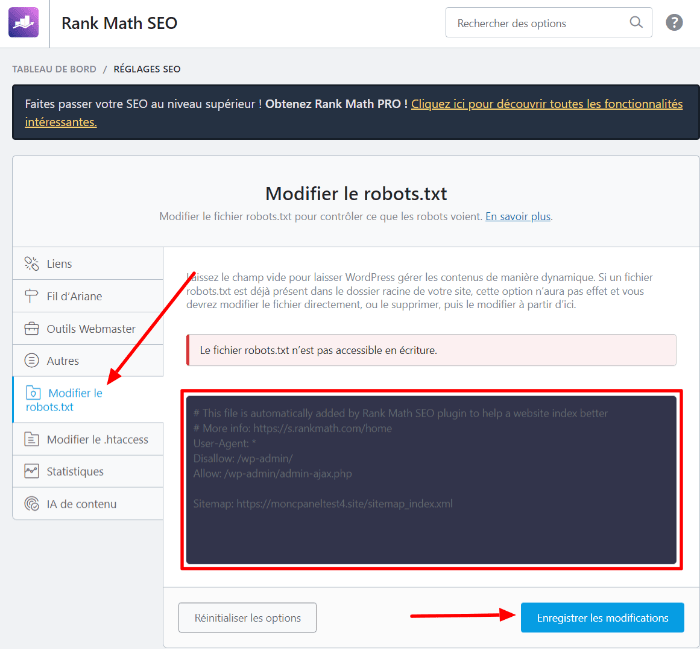

Ensuite, accédez à la section « Rank Math › réglages généraux ». Dans l’interface suivante, accédez à la section « Modifier le robots.txt ».

Dans l’interface suivante, accédez à la section « Modifier le robots.txt ». Si un fichier robots.txt est déjà disponible à la racine de votre site, vous ne pouvez pas ajouter un fichier robots.txt supplémentaire. Vous devez donc supprimer celui qui existe déjà afin d’avoir la possibilité de créer un nouveau.

Si un fichier robots.txt est déjà disponible à la racine de votre site, vous ne pouvez pas ajouter un fichier robots.txt supplémentaire. Vous devez donc supprimer celui qui existe déjà afin d’avoir la possibilité de créer un nouveau.

Ensuite, ajoutez les règles nécessaires et définissez tous les dossiers que vous ne souhaitez pas que les moteurs de recherche indexent. Une fois que vous avez terminé, cliquez sur le bouton « Enregistrer les modifications ».

Méthode 3 : créer manuellement un fichier robots.txt

Si vous ne voulez pas créer votre fichier robots.txt en utilisant un plugin, alors vous pouvez le faire manuellement. Cette option vous permet d’ajouter un fichier robots.txt sur n’importe quel site. C’est aussi une charge de moins pour votre base de données, car vous n’aurez pas besoin d’installer un plugin le faire.

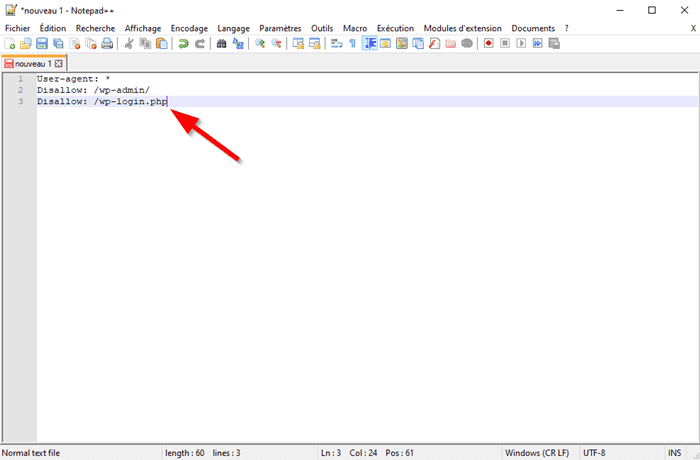

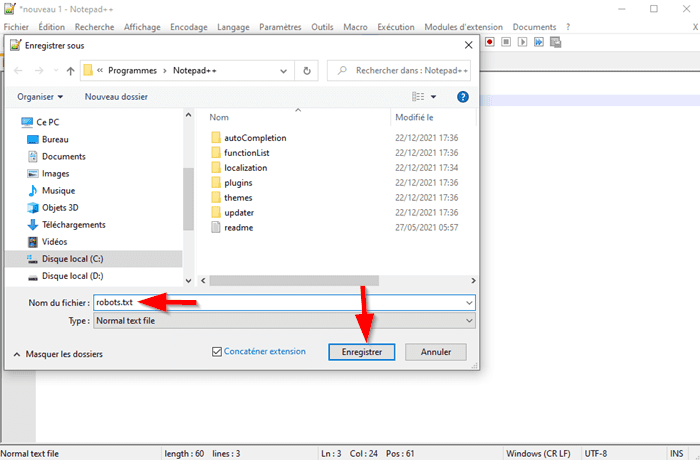

Pour utiliser cette méthode, vous devez avoir un éditeur de texte comme Notepad++. Ouvrez votre éditeur de texte et ajoutez toutes les règles nécessaires à votre fichier. Ensuite, enregistrez votre fichier sous le nom de robots.txt

Ensuite, enregistrez votre fichier sous le nom de robots.txt Une fois que vous avez créé votre fichier et l’enregistrer sur votre ordinateur, connectez-vous à votre site en utilisant un client FTP tel que FileZilla.

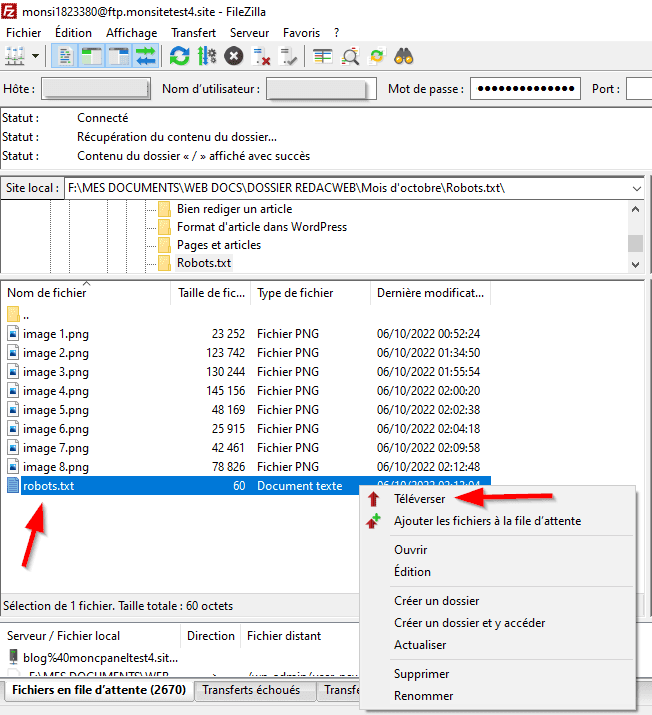

Une fois que vous avez créé votre fichier et l’enregistrer sur votre ordinateur, connectez-vous à votre site en utilisant un client FTP tel que FileZilla.

Trucs et astuces

Si vous hébergez votre site chez LWS, vous n’avez pas besoin d’installer un logiciel client FTP ! Utilisez le gestionnaire de fichiers cPanel ou le File Manager LWS Panel, selon la formule d’hébergement web choisie, pour télécharger votre fichier robots.txt sur le serveur.

Accédez à la racine de votre site et téléchargez le fichier robots.txt que vous avez créé. Une fois que vous avez terminé le téléchargement, c’est tout !

Une fois que vous avez terminé le téléchargement, c’est tout !

Quelques règles que vous pouvez utiliser avec le fichier robots.txt

Bloquer l’exploration de l’ensemble de votre site

Pour interdire à tous les robots de moteurs de recherche d’explorer votre site, vous pouvez ajouter les règles ci-dessous dans votre fichier robots.txt.

User-agent: * Disallow: /

Le symbole / représente l’ensemble de dossiers de votre site.

Interdire l’exploration d’un site à un robot spécifique

Vous voudrez peut-être qu’un robot X n’explore votre site. Votre fichier robots.txt peut ressembler à celui-ci :

User-agent: Yandoxbot Disallow: /

Comme vous pouvez le voir l’astérisque est remplacé par le robot Yandexbot. Une fois que vous enregistrez votre fichier, vous avez interdit l’exploration uniquement au robot de Yandex.

Trucs et astuces

Le site User Agent String.Com répertoire les noms de robots que vous pouvez utiliser dans votre fichier robots.txt.

Autoriser l’accès à un fichier spécifique dans un dossier non autorisé

Vous pouvez aussi bloquer un dossier entier et ensuite, permettre aux robots d’accéder à un fichier spécifique. Dans ce cas, votre fichier robots.txt peut ressembler à l’exemple ci-dessous :

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Dans ce fichier robots.txt, vous avez bloqué l’accès à l’ensemble de fichiers du répertoire /wp-admin sauf au fichier /wp-admin/admin-ajax.php.

Bloquer l’accès à un fichier spécifique à tous les robots de moteur de recherche

Vous voudrez peut-être bloquer l’indexation d’un fichier spécifique par tous les moteurs de recherche. Dans ce cas, vous pouvez créer un fichier robots.txt qui ressemble à celui-ci :

User-agent: * Disallow: */feed/

Dans ce fichier, vous avez bloqué l’accès aux pages de flux RSS de votre site.

Créer des règles différentes pour différents bots dans le Robots.txt

Supposons que vous voudrez appliquer une règle à tous les bots de moteurs de recherche et une autre règle à un bot spécifique. Votre fichier robots.txt peut ressembler à celui-ci :

User-agent: * Disallow: /wp-admin/ User-agent: Googlebot-Image Disallow:/

Dans cet exemple, vous avez bloqué l’accès à tous les bots au répertoire /wp-admin. En plus, vous avez ordonné au robot Googlebot-image de ne pas explorer votre site.

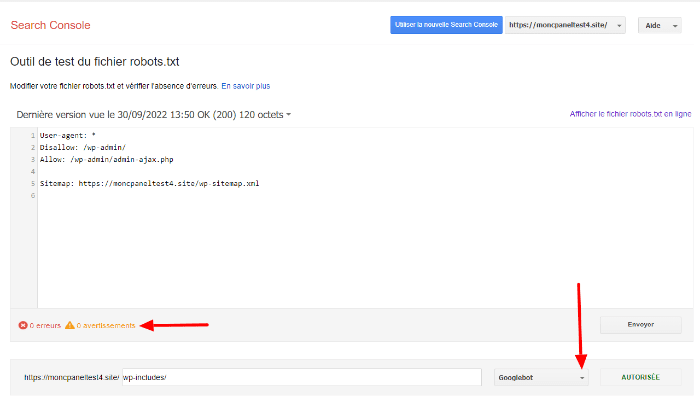

Tester votre fichier robots.txt

Vous devez ensuite tester votre fichier afin de vous assurer qu’il fonctionne correctement. La manière la plus facile de procéder consiste à utiliser l’outil de vérification de Google Search Console de Search Console.

Rendez-vous sur la page d’accueil de l’outil et collez le contenu de votre fichier dans la zone d’édition prévue.

Une fois que vous avez terminé, l’outil va détecter les erreurs éventuelles et les afficher si elles existent. Comme vous pouvez le voir, notre fichier ne contient aucune erreur. Ce qui traduit par le résultat « 0 erreurs et 0 avertissements ».

Comme vous pouvez le voir, notre fichier ne contient aucune erreur. Ce qui traduit par le résultat « 0 erreurs et 0 avertissements ».

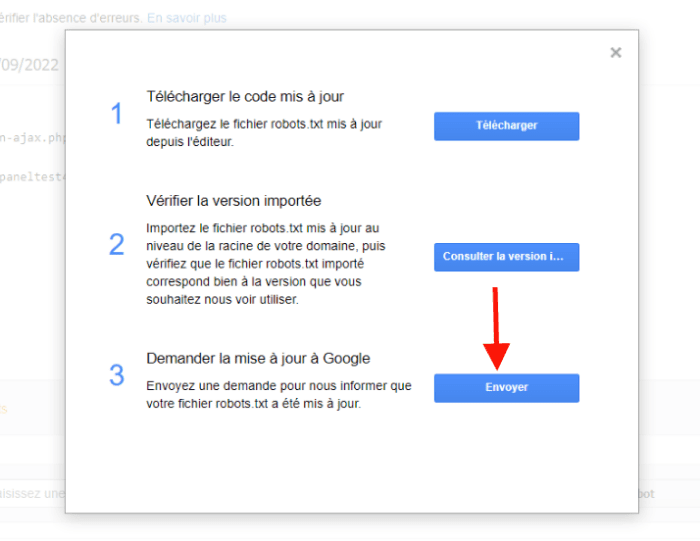

Cliquez ensuite sur le bouton « Envoyer » pour demander à Google de mettre à jour manuellement le fichier robots.txt de votre site.

Conclusion

🥳Toutes félicitations d’avoir lu cet article. Le fichier robots.txt vous permet de bloquer l’exploration et l’indexation de certaines parties de votre site par certains bots de moteurs de recherche. Dans cet article, vous avez découvert ce qui est le fichier robots.txt, son importance et la façon de le créer sur votre site.

Avez-vous des questions sur la façon de gérer le fichier robots.txt WordPress ? Utilisez la section Commentaires pour nous écrire.

37mn de lecture

37mn de lecture

Commentaires (0)